לפני שבוע שתי ועדות של הפרלמנט האירופי אישרו את הפשרה בין הפרלמנט לנציבות (ה"ממשלה") של האיחוד האירופי לגבי החוק. בכך נסללה הדרך לחוקק את החוק ובקרוב מאוד הוא יתקבל באופן רשמי. למי שרוצה להעמיק – כתבתי כאן לפני חצי שנה כאשר הצעת החוק אושרה בפרלמנט האיחוד האירופי. ולפני שלושה שבועות ניתחתי והצגתי איך לדעתי כדאי לבנות את הרגולציה על בינה מלאכותית.

המטרה של הפוסט הזה היא להציג לכם את החוק שעומד להתקבל, לפי הנוסח שאושר והוסכם.

זו סקירה רוחבית ולא מאוד מעמיקה. כדי שלא להאריך מאוד, לא אוכל להיכנס לכל ההיבטים והסוגיות. אם תכתבו לי שהנושא מעניין אתכם – יש סיכוי שהפוסט הזה יהפוך לסדרה עם עוד חלקים.

מוכנים? בואו נצלול לחוק ונראה מה מחכה לנו.

לבקשת הקהל – הכנתי גרסת pdf של הפוסט של ואפשר להוריד אותה ממש כאן.

על מה מדובר? מהו חוק ה-AI?

חוק ה-AI הוא המסגרת החוקית-רגולטורית שמיועדת להסדיר את המכירה ואת השימוש בבינה מלאכותית באיחוד האירופי. מטרתו הרשמית היא להבטיח את התפקוד התקין של השוק על ידי קביעת סטנדרטים עבור מערכות בינה מלאכותית במדינות החברות באיחוד האירופי.

זו הרגולציה המקיפה הראשונה בעולם שמתייחסת לסיכונים מבינה מלאכותית ומטפל בהם באמצעות מערכת של חובות ודרישות שמטרתן לשמור על הבריאות, הבטיחות וזכויות יסוד. בגלל שהאיחוד האירופי הוא שוק ענק עם סחר בין-לאומי מפותח ולאור ההגדרות הרחבות בחוק, לחוק צפויות להיות השפעות בקנה מידה עולמי.

1. על מי החוק חל?

ההגדרה בחוק הסופי רחבה מאוד. החוק חל על מערכת בינה מלאכותית ("AI system"). איך החוק מגדיר את זה? ככה:

"a machine-based system designed to operate with varying levels of autonomy and that may exhibit adaptiveness after deployment and that, for explicit or implicit objectives, infers, from the input it receives, how to generate outputs such as predictions, content, recommendations, or decisions that can influence physical or virtual environments"

המוקד של ההגדרה הזו היא האוטונומיות של המערכת. זאת אומרת, המערכת מתפתחת, לומדת ומשתנה. בניגוד למערכת טכנית שהתוצאה או הפלט שלה ודאיים וידועים מראש. עוד מילת מפתח מעניין היא "infers" – בעברית: "מסיק מסקנות". זאת אומרת, אנחנו מדברים על מערכות אוטונומיות שהן גם מערכות חושבות. ההגדרה הזו צלצלה לי מוכר. נראה לי שהם אימצו את ההגדרה של ה-OECD.

ההגדרה בנוסח הסופי שונה מההגדרה בהצעת החוק המקורית, שהתבססה על רשימה יותר סגורה ומוגדרת של טכנולוגיות.

לשינוי ההגדרה יש כמה השפעות: נראה שזו הגדרה רחבה יותר שתחול על יותר מערכות; היא ניטרלית מבחינה טכנולוגית; ובגלל שזו הגדרה מהותית ולא טכנית – נראה שהיא תהיה רלוונטית למשך יותר זמן.

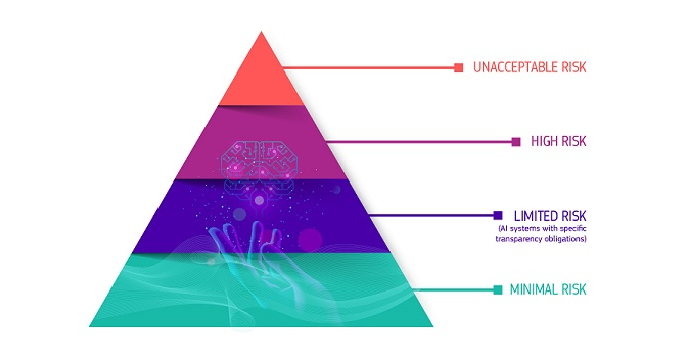

2. המודל המרכזי של החוק: ניהול סיכונים

החוק מתבסס על גישה של ניהול סיכונים. הם חילקו את המערכת והתרחישים השונים לארבע קבוצות:

- סיכון בלתי נסבל (unacceptable risk);

- סיכון גבוה (high risk);

- סיכון נמוך / מוגבל (limited risk);

- סיכון מינימלי / מזערי (minimal risk).

מערכות שיוצרות סיכון בלתי נסבל

מערכות ושימושים שיוצרים סיכון בלתי נסבל יהיו אסורים. בקבוצה הזו נכללים: מערכות שמנצלות חולשות אנושיות (של קבוצה או של הפרט), מערכת ניקוד חברתי, ועוד.

במקור, רשימת האיסורים המוחלטים כללה גם שימוש ב-AI לזיהוי ביומטרי בזמן אמת למטרות אכיפת חוק (למשל, מצלמות שמבצעות זיהוי פנים כדי לאתר פושעים). בחודשים האחרונים היה באירופה דיון מקיף על האיסור הזה, כי הממשלות וגופי אכיפת החוק מאוד רוצים להשתמש ב-AI למלחמה בפשיעה ובטרור. בנוסח הסופי, ריככו את האיסור והוסיפו חריגים. הוחלט לקבוע חריג לאיסור המוחלט הזה: מותר יהיה להשתמש בזיהוי ביומטרי בנוגע לרשימה של מטרות מותרות כמו חיפוש וזיהוי קורבנות של סחר בבני אדם או עבירות מין; או לצורך מניעת מתקפות טרור. גם כשהחריג חל, ההפעלה שלו לא פשוטה – צריך לבצע בחינה מעמיקה, ולקבל צו שיאשר את זה.

מערכות שיוצרות סיכון גבוה

מערכות שיוצרות סיכון גבוה – יהיו כפופות לשורה של מגבלות, חובות ותנאים. זו ליבת החוק. במקור פרלמנט האיחוד האירופי העריך שרק 20% מהמערכות והמוצרים יפלו לקבוצה הזו. שמעתי הערכות שהמספר האמיתי כנראה גבוה יותר.

מערכות ברמת סיכון נמוכה

מערכות שיוצרות סיכון נמוך – יהיו כפופות בעיקר לחובות שקיפות (לפי ההערכות של האירופים הרוב המכריע של המערכות נופלות בקבוצה הזו) והוראותיו די פשוטות.

מערכת שיוצרת סיכון מינימלי. על מערכת כאלה אין דרישות מכוח החוק.

עיקר המשחק והדיון הוא בין הקבוצה שבסיכון גבוה לקבוצה שבסיכון נמוך.

3. החובות שחלות על מערכת בסיכון גבוה

גם פה צריך להתחיל בהגדרה – מה היא מערכת בסיכון גבוה? החוק קובע שתי חלופות להגדרה של מערכת ככזו בסיכון גבוה:

- מערכת AI שמיועדת לשמש כמוצר (או רכיב) שכפוף לחקיקה ספציפית של האיחוד האירופי, כמו תעופה, אבטחת רכב, ציוד ימי, צעצועים, מעליות, וציוד מגן אישי.

- מערכות AI שמפורטות בנספח 3 לחוק. הנספח כולל מערכות זיהוי ביומטרי מרחוק (אבל לא בזמן אמת / לאכיפת חוק), מערכות שהן חלק מרכיב בטיחות בתשתיות קריטיות ומערכות שמשמשות בתחומי החינוך, תעסוקה, ניקוד אשראי, אכיפת חוק, הגירה ותהליך דמוקרטי.

אבל תחת החלופה הזו יש חריג: אם המערכת לא יוצרת סיכון משמעותי לבריאות, לבטיחות או לזכויות אדם בסיסיות – היא לא תחשב כמערכת בסיכון גבוה (ותסווג כמערכת בסיכון נמוך). בכל מקרה, גם מערכת שנכנסת תחת החריג, צריכה להירשם כמערכת בסיכון גבוה שקיבלה חריג.

הקבוצה הראשונה מזהה תחומים לפי העובדה שכבר יש עליהם רגולציה, ולכן זה פרוקסי לכך שרמת הסיכון בהם גבוהה. הקבוצה השניה מפנה לרשימה של תחומים רגישים, שמספיק שנוגעים בהם – ומדובר בסיכון גבוה.

ההגדרה לא סגורה לחלוטין ולכן עוד צפויים דיונים סביב הפרשנות של ההוראות והחריגים שלהם. אולי זה יהיה בנהלים של נציבות האיחוד האירופי ואולי זה יגיע גם לבתי המשפט.

למשל, החריג לחלופה השניה (מערכת בתחום רגיש מתוך הרשימה שבנספח 3, אבל שלא יוצרת סיכון לבריאות, בטיחות או זכויות בסיסיות) – יהיה מאוד חשוב. החריג מתאים מאוד למערכות שמבצעות משימה טכנית ו"סגורה", או מערכת שמשלימה פעולה אנושית אבל לא מחליפה שיקול דעת אנושי ולא מבצעת פעולה חדשה, או מערכת שכפופה לבקרה אנושית. מצד שני, אם המערכת מסווגת בני אדם לקטגוריות, למשל באמצעות profiling- היא תחשב מערכת בסיכון גבוה.

הרבה חברות (ומדינות שמשתמשות ב-AI) ירצו להיכנס לגדרי החריג ויטענו שהמערכת שלהן לא מציבות סיכון לבריאות, לבטיחות או לזכויות בסיסיות. זה עומד להיות מוקד מרכזי בעיסוק סביב החוק.

ומה החובות עצמן?

מערכת AI בסיכון גבוה תהיה כפופה למשטר מחמיר של דרישות רבות. למשל – המפעיל / ספק של המערכת נדרש לבצע הערכת סיכונים, להתבסס על מידע באיכות גבוהה, לתעד את ההחלטות המרכזיות בפיתוח ובאימון המערכת (גם במישור האתי וגם במישור הטכנולוגי), לאסוף ולשמור תיעוד על הביצוע של המערכת, לגלות למשתמשים מידע על התכלית של המערכת, לוודא שיש פיקוח אנושי שמסוגל להתערב בפעילות של המערכת ועוד.

דרישה נוספת היא לבדוק מראש שהמערכת עומדת בדרישות של החוק, לפני הפעלה מסחרית שלה ולפני מכירה שלה. כמו שהזכרתי קודם, המערכות ברמת סיכון גבוהה ירשמו במרשם מסודר של האיחוד האירופי שגם יהיה נגיש לציבור.

ויש עוד חובות: על משתמשים, מפיצים ועוד

בכל הנוגע למערכות בסיכון גבוה, החוק מטיל חובות רבות על המון שחקנים. העיקרון הזה מרחיב מאוד את מעגל המפוקחים. למשל, קניתם מוצר שיש בתוכו רכיב AI – מזל טוב, אתם כפופים לחוק (תרשמו, תתחילו לתעד, תבצעו הערכת סיכונים ועוד ועוד).

החוק מטיל חובות על הספק (provider) של מערכות בסיכון גבוה, וגם על מי שמיישם אותה (deployer). החוק חל גם על מעגל שני: על מי שייבא או מכניס אותה לאיחוד האירופי (importer), למי שמפיץ (distributor). היבואן והמפיץ בעיקר צריכים לאמת שהמערכת שהם מכניסים או משווקים באיחוד האירופי עומדת בכללים. על פניו מצבם הכי טוב כי הם לא "פותחים את הקופסה" ולכן הם נדרשים רק באימות מבחוץ.

המיישם צריך להבטיח שיהיה פיקוח אנושי על המערכת – גם ברמת הביצועים וגם כדי לתעד, לאסוף ולנתח את המידע על הפעילות שלה. חובת שמירת המידע חלה במינימום למשך שישה חודשים.

4. חובות מיוחדות על ממשלות וגופים פיננסים

אם גוף ציבורי או גוף פיננסי (למשל, בנק או חברת ביטוח) רוצים להשתמש במערכת AI בסיכון גבוה – חלות עליהן בנוסף עוד הוראות. בדרך כלל הגופים האלו יפלו בקלות לאחת ההגדרות של מערכת בסיכון גבוה.

הם נדרשים לבצע מראש הערכת השפעות על זכויות בסיסיות, או בקיצור – FRIA. זה האח הקטן והטרי של הערכת השפעות רגולציה (RIA – regulatory impact assessment). החוק מגדיר מסגרת לביצוע ה-FIRA: זיהוי הסיכונים, זיהוי הגופים שחשופים לסיכון (וניתוח לאילו קבוצות הם משתייכים), הגדרת אמצעי בקרה, עצמאיים, הגדרת צעדים לצמצום הסיכון, בחינת תדירות השימוש הצפוי במערכת ועוד. זה כאב ראש משמעותי, וכמובן שברגע שהחובה הזו קיימת, אותם גופים חשופים לתביעות בטענה שהם לא ביצוע את ה-FIRA כמו שנדרש לפי החוק.

5. הזכות לקבל הסבר על החלטות שהתקבלו

ברקע חקיקת חוק ה-AI עמד דיון משפטי אחר: האם רגולציית הפרטיות של האיחוד האירופי (GDPR) מעניקה לאדם זכות לקבל מידע והסבר על החלטה שמערכת קיבלה לגביו אם בקר אנושי היה מעורב בהחלטה שיש לה משמעות משפטית או משמעות דומה. למשל, אם בקר אנושי משתמש במערכת AI והתקבלה החלטה לשלול ממני זכות מסוימת – האם יש לי זכות משפטית לקבל הסבר על אופן קבלת ההחלטה? הזכות לקבל הסבר עומדת כמובן במתח ישיר עם בעיית הקופסה השחורה והקושי להסביר החלטות של מערכות AI.

חוק ה-AI מבהיר את הנקודה הזו: הזכות קיימת ביחס למערכות בסיכון גבוה לפי הרשימה שבנספח 3 לחוק.

התוצאה – בקרוב אנחנו נראה מאבקים משפטיים סביב אנשים פרטיים שדורשים לקבל הסברים להחלטות של מערכת AI, לבין חברות טכנולוגיה וגופים שמשתמשים במערכות האלו, שלא ירצו לחשוף את המידע. יש סיבות טובות להתנגד לחשוף את המידע. את הראשונה הזכרתי – הקושי למסור מידע על מערכת אטומה שלא לגמרי ברור לנו איך היא מקבלת החלטות. סיבה נוספת היא שאם המידע הזה זמין, הוא עשוי להיות סוד מסחרי. הרי, המוצר הוא מערכת שמקבלת החלטות. אז אם נחייב אותם לחשוף איך המערכת מקבלת החלטות (פרמטרים, שיטת ניתוח) , נוציא את העוקץ.

6. חובות השקיפות

כל המערכות שכפופות לחוק נדרשות בחובות השקיפות. מערכות בסיכון נמוך יהיו כפופות בעיקר לחובות האלו. ההגדרה בחוק די רחבה והיא תופסת את רוב מה שנשאר ולא נכלל בקטגוריות של סיכון בלתי נסבל (איסור) וסיכון גבוה (מגבלות קשות). תמצאו בתוכה מערכות שאמורות לתקשר ישירות עם בני אדם, מערכות יוצרות (chat GPT, midjourney) ועוד.

במקרים האלו יש חובה ליידע את המשתמש שמולו ניצבת מערכת שיש בה AI.

בנוסף, המידע והפלט של המערכת יהיה צריך לאפשר סימון / זיהוי שמדובר בתוכן שנוצר או שונה על-ידי מערכת AI.

7. הפיקוח והאכיפה

מי שיפר את החוק חשוף לקנס של עד 35 מיליון אירו או עד 7% מהמחזור העולמי של המפר (שימו לב: לא הרווח, אלא כל המחזור העסקי; ולא רק באירופה, אלא בכל העולם). גובה הקנס יהיה בהתאם לחומרת ההפרה.

החוק יוצר מספר גופים ובעלי תפקידים כמו ה-AI Office וה-AI Board, שלא התעמקתי בהבדל ביניהם. היישום, הפיקוח והאכיפה של החוק יעשו על-ידי הרגולטורים במדינות השונות שחברות באיחוד. בנוסף, מערכת שהחוק מחייב חלק מהמפוקחים לבצע תהליך הערכה עצמית (FRIA) – גם הם לוקחים חלק ביישום של החוק ויהיו בממשק אינטנסיבי עם הרשויות.

בהקשר של היישום והפיקוח, מעניין לציין שהאיחוד האירופי כבר פרסמו באתר שלהם לינק למעין שאלון "בחן את עצמך", שעוזר למפוקח להבין האם המערכת שלו עומדת בהוראות החוק. זה מאוד יפה – מאפשר למפוקח לבדוק את עצמו, ואז כמובן לתקן.

8. מתי החוק יכנס לתוקף?

האירופים יחוקקו את החוק בקרוב. ברגע שזה יקרה, תתחיל ספירה לאחור של מספר מועדים:

- בתוך חצי שנה – ייכנס לתוקף האיסור על שימוש במערכות שיוצרות סיכון קריטי (זאת אומרת שהאיסור המוחלט יכנס לתוקף ראשון);

- בתוך שנתיים (זאת אומרת, 2026) יכנסו לתוקף רוב ההוראות של החוק לגבי מץ.ערכות בסיכון נמוך ומערכות בסיכון גבוה שנכללות תחת החלופה הראשונה (פעילות שיש עליה רגולציה מסוג שהוגדר).

נקודה מעניינת נוספת: בתוך שנתיים תחול חובה להקים ארגזי חול רגולטוריים ( regulatory sandbox). לפי החוק כל מדינה תקים לפחות ארגז חול רגולטורי אחד לתחום ה-AI בכמה הלאומית. החוק מתיר למדינות להקים ארגז חול משותף. - בתוך שלוש שנים (זאת אומרת, 2027) יכנסו לתוקף החובות שחלות על מערכות בסיכון גבוה שנכללות תחת החלופה השניה (תחומים מוגדרים כמו חינוך, תעסוקה, ניקוד אשראי, אכיפת חוק ועוד).

- בתוך ארבע שנים (זאת אומרת, 2028) החוק יחול על מערכות בסיכון גבוה שנמצאות בשימוש של גופים ציבוריים והיו בשימוש לפני שהחוק נכנס לתוקף. אולי תקופת המעבר הזו תיצור תמריץ לממשלות להפעיל באופן מיידי מערכות כאלו, כדי להנות מהתחולה המאוחרת. האם זה יגרום לגופים הציבוריים להעלות לאוויר מערכות לא בשלות (לא יציבות, לא בטוחות) רק כדי שיהיו בשימוש לפני שהחוק נכנס לתוקף?

זה אומר שייקח קצת זמן, אבל החוק הזה יתחיל לעשות גלים.

ובגלל התחולה הרחבה (הגדרה רחבה + מעגלים של שחקנים) – הוא ישפיע גם מחוץ לאירופה.

9. תם ולא נשלם: סוגיות רוחב נוספות

אפשר להעמיק בחוק הזה עוד ועוד, אבל לסיכום אני רוצה להסתכל רחב. החוק הזה הוא רק חלק בפאזל של החקיקה והרגולציה על בינה מלאכותית. כדי להסדיר את הפעילות הזו ולהתאים את הכללים לעולם עם AI, יהיה צורך בעדכון של עוד רגולציות ועוד חוקים.

למשל:

- סייבר: זה הכי מתבקש. ככל שהעולם הופך יותר דיגיטלי וככל שמערכות דיגיטליות מבצעות פעולות יותר קריטיות, כך הגנת הסייבר הופכת להיות קריטית. אני לא יודע איך, אבל רגולציית הסייבר גם תתאים את עצמה לשינויים שמערכות בינה מלאכותית יביאו.

- קניין רוחני: כל מערכת ה-AI ש"יוצרות", לא באמת יוצרות. הן לומדות טקסטים, תמונות, מוזיקה, ויצירות אחרות – ועל בסיסן יודעות לתת פלט או לנתח משהו. אם אימנתי את מערכת ה-AI על ספר שמישהו כתב או על תמונה שמישהו צייר – מה המשמעות בהיבטי זכויות היוצרים?

- דיני חוזים ודיני נזיקין: להבהיר מי אחראי לנזקים, מצגי שווא, הפרות חוזה ועוד שמבוצעים כאשר מערכת AI מעורבת?

חלק מהפאזל הזה כבר קיים. האיחוד האירופי מרכיב את הרגולציה שלו לעידן הדיגיטלי חתיכה אחר חתיכה. הזכרתי את ה-GDPR לעניין הפרטיות. יש עוד שני חוקים חדשים יותר: ה-Digital Services Act (עוסק בשקיפות ובהגנה על המשתמשים) וה-Digital Markets Act (קובע כללים עבור הפלטפורמות הדיגיטליות, כדי לקדם תחרות).

החוק הזה עומד להשפיע על הכלכלה העולמית ועל החברה שלנו.

תהיה לו השפעה דרמטית. לא פחות. חשוב להבין ולהכיר אותו.

הסקירה כאן היתה מאוד כללית ומבלי להיכנס להמון סוגיות ודילמות שהחוק מעלה.